VMware Virtual SAN (vSAN) это высокопроизводительное решение для хранения данных корпоративного класса для гиперконвергентной инфраструктуры. vSAN позволяет объединять SSD накопители и обычные диски, подключенные к локальным ESXi серверам, в общее высокоустойчивое хранилище данных, к которому могут обращаться все узлы кластера vSphere. Если ранее для обеспечения высокой доступности администраторам VMware нужно было использовать SAN, NAS или DAS, то в случае vSAN потребность в выделенном внешнем общем хранилища исключается, при этом добавляется новый программный уровень, который может использовать локальные диски отдельных локальных серверов для обеспечения такой же отказоустойчивости и набора функций SAN.

Поддержка vSAN встроена в ядро гипервизора, благодаря чему решения по выполнению операций ввода/вывода и перемещению данных принимаются максимально быстро (большинство других решений организации виртуальных сред хранения реализуется в виде отдельного аплайнса, работающего над гипервизором). В этой статье мы расскажем об основных особенностях VMware vSAN и покажем процесс развертывания и настройки vSAN 6.5.

Основные возможности VMware vSAN

- Встроенный функционал защиты и обеспечения высокой доступности данных с отказоустойчивостью, асинхронной репликацией на большие расстояния и растянутыми кластерами между географически разнесенными сайтами.

- Использование распределенного RAID и зеркалирования кэша для защиты данных от потери отдельного диска, сервера или целой стойки

- Минимизация задержек хранилищ за счет ускорения операций чтения/записи с дисков за счет встроенного кэша на сервере, хранящиегося на локальных SSD дисках

- Программная дедупликация и сжатие данных при минимальными затратами ресурсов CPU и памяти

- Возможность без простоя наращивать емкость и производительность сети хранения за счет добавления новых серверов и дисков

- Политики хранения виртуальных машин позволяют автоматизировать балансировку и выделение ресурсов хранения и QoS.

- Полная интеграция со стеком VMware, включая vMotion, DRS, высокую доступность (High Availability), отказоустойчивость (Fault Tolerance), Site Recovery Manager, vRealize Automation и vRealize Operations.

- Поддержка iSCSI подключений

- Возможность прямого подключения двух улов перекрёстным кабелем (VSAN Direct Connect).

- Полная поддержка vSphere Integrated Containers для запуска контейнеров для DevOps на vSAN

- Нет необходимости разворачивать дополнительные компоненты, виртуальные машины и интерфейсы управления.

VMware vSAN: системные требования

- Требуется VMware vCenter Server 6.5 и хосты с ESXi 6.5

- Минимум 3 хоста в кластере (максимум 64), однако можно реализовать vSAN и на двух хостах, но потребуется отдельный хост-свидетель

- Каждый сервера ESXi в кластере vSAN должен иметь как минимум один SSD диск (флешку) для кэша, и как минимум один SSD/HDD для данных

- Наличие SATA/SAS HBA или RAID-контроллера в режиме pass-through или в режиме RAID 0

- Минимум 1 ГБ сетевая карта (рекомендуется 10 Гб)

- Все хосты должны быть подключены к сети vSAN через сеть L2 или L3

- На физических коммутаторах, которые обрабатывают трафик vSAN должна быть включено многоадресное вещание (мультикаст)

- Поддерживаются как IPv4 так и IPv6.

- Информацию о совместимости с конкретным железом нужно смотреть в соответствующем документе на сайте VMware

Лицензирование VMware vSAN

vSAN лицензируется в расчете по CPU, виртуальным машинам или конкурентным пользователю и поставляется в трех редакциях: Standard, Advanced и Enterprise.

- Enterprise лицензия – требуется для использования QoS и растянутых кластеров

- Advanced лицензия нужна для поддержки дедубликации, сжатия и RAID 5/6

- Standard – базовый функционал

Лицензия vSAN можно использовать на любой версии vSphere 6.5.

Есть дополнительные способы сэкономить за счет использовании пакета Virtual SAN для ROBO, или приобретения набора лицензий Standard илиAdvanced в количестве 25 штук для удаленных филиалов. Более подробную информацию о лицензировании vSAN смотрите на сайте VMware.

Настройка сети и портов vSAN

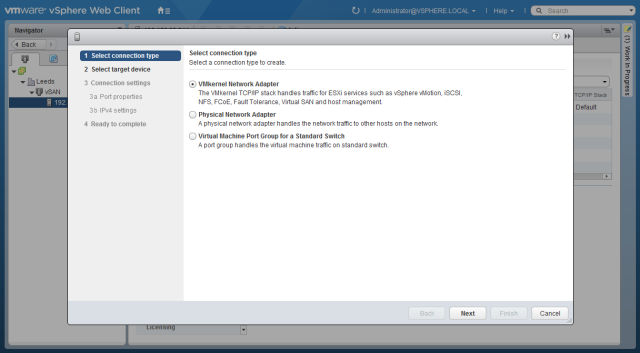

Перед настройкой vSAN нужно убедится, что на каждом хосте кластере настроен порт VMkernel для трафика vSAN. В веб-клиенте vSphere по очереди выберите каждый сервер, на котором вы хотите использовать vSAN. Выберите вкладку Configure-> Networking -> VMKernel Adapters -> нажмите Add Host Networking. Убедитесь, что выбран тип VMkernel Network Adapter и нажмите Далее.

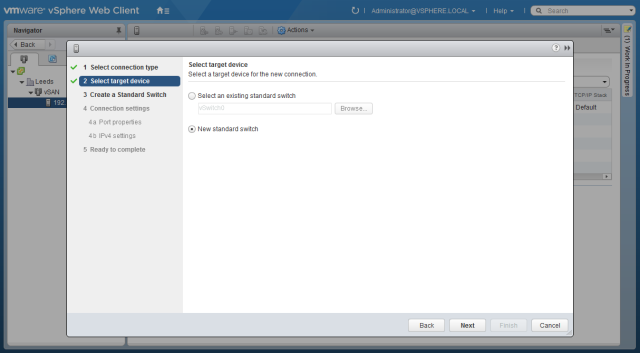

Создайте новый виртуальный коммутатор (New standard switch) и нажмите Next.

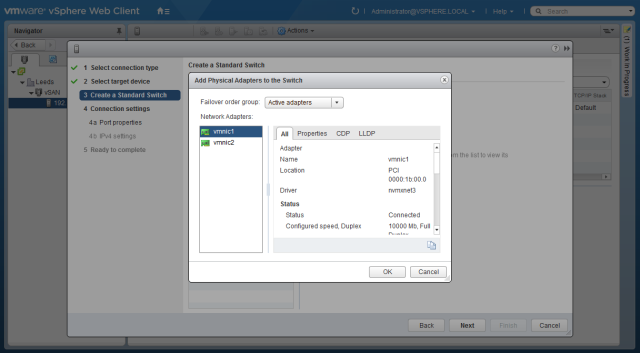

С помощью зеленого значка плюса привяжите физические адаптеры к коммутатору. В продуктивных средах желательно обеспечить дополнительное резервирование за счет использования несколько физических NIC.

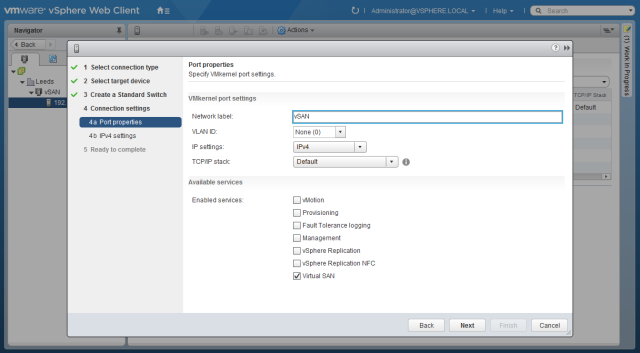

Укажите имя порта VMkernel и, если нужно, его VLAN ID. Обязательно поставьте галку напротив опции Virtual SAN и нажмите Next.

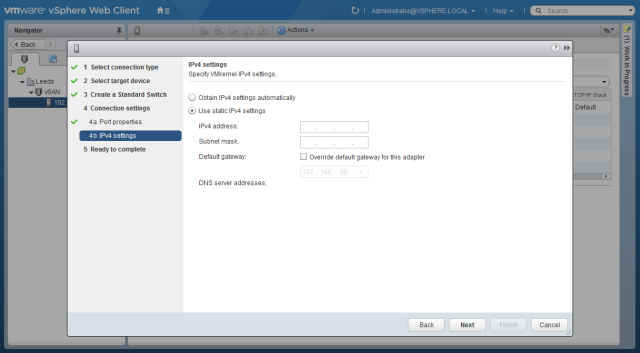

Укажите сетевые параметры порта VMkernel.

Если вы настраиваете сеть vSAN на тестовом стенде с ограниченным количеством физических интерфейсов, выберите сеть управления (Management Network) и в списке поддерживаемых служб поставьте галку у пункта Virtual SAN. При такой конфигурации трафик vSAN будет идти через общую сеть управления, чего в продуктивных развертываниях делать не стоит.

Настройка vSAN

Как мы уже говорили, для настройки vSAN дополнительно доставлять что+то на гипервизор не нужно, весь функционал уже имеется. Вся что требуется от администратора – настроить vSAN через интерфейс веб клиента vSphere (vSAN пока не поддерживает модный HTML5 клиент).

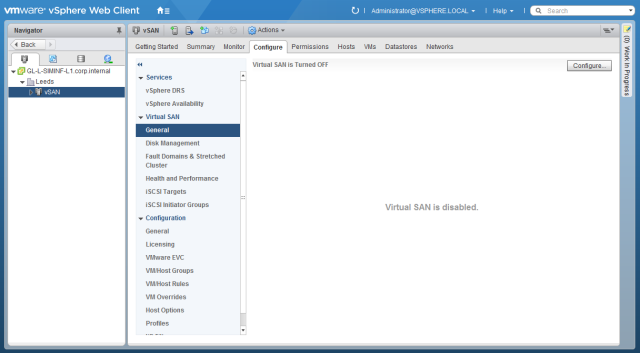

Чтобы включить vSAN найдите нужный кластер в консоли vSphere и перейдите на вкладку Configure. Разверните раздел Virtual SAN и выберите General. В нем должно быть указано, что Virtual SAN не включен. Нажмите на кнопку Configure.

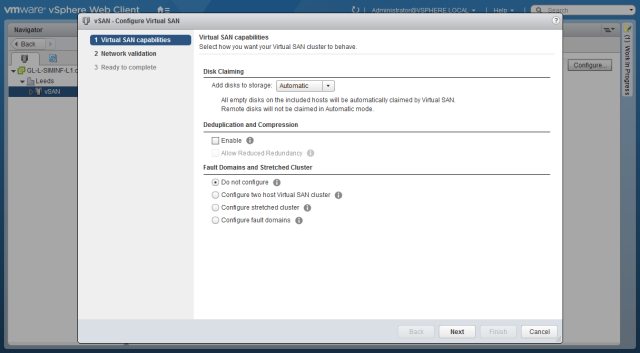

По умолчанию в хранилище vSAN будут добавлены любые подходящие диски. Чтобы вручную выбрать диски, измените параметр назначения дисков на Manual. Здесь же можно включить опцию сжатия данных, отказоустойчивости.

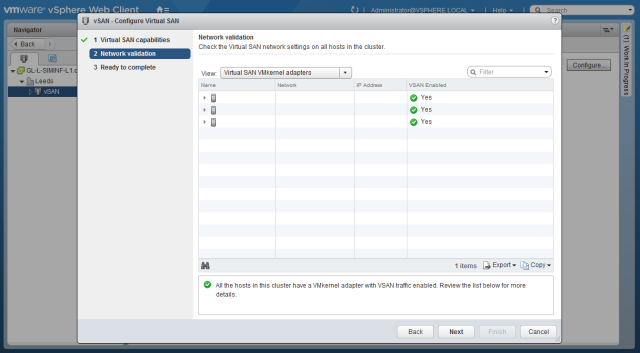

На странице валидации сети должны появится подтверждения о том, что каждый хост в кластере подключен к сети vSAN.

Проверьте выбранные настройки и нажмите Finish. Дождитесь окончания выполнения задачи, после чего виртуальная сеть SAN объединит все локальные диски серверов выбранного кластера в распределенное хранилище vSAN. Данное хранилище представляет собой один единый VMFS датастор, на который вы сразу же можете поместить виртуальные машины. Настройки vSAN в дальнейшем можно будет изменить в том же разделе (вкладка кластера Configure -> Virtual SAN).

Строю кластер из пяти серверов. Если в каждом сервере два диска SSD, то возможно ли использовать vsan без cash tier?

Cache Tier это по сути выделенаня область на каждом сервере, куда кэшируются данные перед помешением в основное хранилище Capacity Tier (перед попаданием в хранилище данные должны быть успешно сохранены в Cache Tier на 2 хостах). Также он используется для более быстрого доступа (данные на этом хранилище находятся в несжатом виде).

Насколько я знаю, отказаться от нее нельзя.

Другой вопрос, что в вашем случае получается конфигурация All-Flash. В этом случае кэш на чтение не используется (но кэш на запись запись все еще нужен).

Вот у меня в каждом сервере ESXi установлено 2 диска по 1Tb SSD. Грузятся ESXi по сети. Сетка 2х10Gb. Добавить дисков больше нет возможности. Если я отдам в каждом сервере один диск под Cache Tier, то потеряю 5Tb.

Как можно организовать общее хранилище в кластере с минимальными потерями дискового пространства?

Рассматривал datastore cluster. Может есть еще решения?

Да, похоже никак. На каждом из серверов придется выделять один физический SSD диск под кэш.

В VSAN 6.0 вроде было отграничение на размер дисковой группы в AllFlash конфигурации (600 Гб). 6.5 пока совсем не крутил.

Добрый день.

Вопрос.

Допустим, имеется 6 compute-нод и 3 ноды под storage.

Обязательно ли включать все серверы кластера в VSAN? Или compute-ноды также могут входить в общий кластер, но не иметь при этом на борту элементов VSAN?

Спасибо.

я бы включил на всех vSAN а дисковые группы создал бы на 3 ноды.

Спасибо, понял, тем более VSAN вроде включается для всего кластера, а не per-host.

Еще вопрос, возможно глупый.

Нигде не нашел, можно ли использовать в качестве capacity-диска логический диск на RAID. С кэш-дисками понятно, это противоречило бы идеологии быстрого кэша на запись. А как насчет capacity? Допустим, в storage-ноде 24 HDD и 2 SSD. Если RAID нельзя отдать в VSAN, то получается, что из общего объема можно собрать 2 дисковых группы по 1 SSD + 7 HDD, и еще 10 HDD либо останутся локальным стораджем, либо пополнят ЗИП (либо и то, и другое =] ). А с RAID5, скажем, все несколько радужнее с т.з. объема, хотя такой бутерброд будет несколько медленнее.

Так можно или нет?

Для vSAN нужно минимум 3 дисковых группы. Проще RAID 6 и подключить к каждой ноде в кластере. Я бы так себе сделал, но у меня всё хлеще. Mellanox, Ib карточки nettap. Ещё и VSAN хочу пустить через mellanox(54Gb).

>Для vSAN нужно минимум 3 дисковых группы.

Ну так 3 сторадж-ноды же, см. мое от 05.06.2018. По одной на каждую — три и получается.

>Проще RAID 6 и подключить к каждой ноде в кластере.

Не, это неинтересно. Хочется отказоустойчивости без применения костыля FT.

>Я бы так себе сделал, но у меня всё хлеще.

Эхх.. =]

В VSAN вы можете создать несколько дисковых групп по 1 Cache (SSD)+ 7 Capacity дисков.

Где-то видел, что есть сервера с 40 локальными дисками, вам ничто не мешает собрать из всех их несколько дисковых групп под vSAN, но в каждой группе обязательно должен быть один SSD.

RAID прокидывать esxi хосту при использовании vSAN не рекомендуется. RAID это уже логический диск, соответственно vSAN не будет видеть всю информацию о диске (smart, ошибки и прочее), значит не сможет мониторить его здоровье, отображать информацию о необходимости его замены.

Если в RAID умрет один из дисков, VSAN это не увидит, т.к. он видит логический диск.

Host is in a vSAN cluster but does not have vSAN service enabled

Сеть настроена корректно.

Галку включили?

Укажите имя порта VMkernel и, если нужно, его VLAN ID. Обязательно поставьте галку напротив опции Virtual SANЭто всё включено. Эта ошибка появилась 25.02.2021 в 9:50 на всех трёх хостах esxi, потом я менял истёкшие сертификаты, просто замучился, выпустив их через active directory, сертификационный центр. До указанной даты всё работало, значит сеть настроена корректно. Почему же сейчас не работает не понимаю, всё перерыл. Может что-то с сертификатами не так. Версия vcenter 6.5 со всеми патчами и обновлениями.

До сих пор не понимаю пожалуйста кто то может обяснять простым языком как работает и функцианирует сервер свидетель? спасибо

Свидетель нужен в ситуациях, когда кластер распадается (некоторые хосты не доступны, сеть отвалилась и т.д.). Оставшиеся в живых хосты вместе со свидетелем объявляют кворум и считают, что держат актуальные копии vsan.

Т.е. в ситуации с двумя хостами vsan представьте ситуацию, что связь между ними пропала. Как каждый из них дожен понять это проблема с другим хостом или с ним. Тот кто видит свидетеля считает, что с его сетью все в порядке. Тот который не видит, понимает что проблема именно с ним и отключает свою копию vsan

спасибо за ответ блогодарен , больше в других операциях не участвует Witness правда понял ? и для каждого raid 1 vm создается свое отдельный witness?

Нет, один witness нужен для каждого vsan кластера, если в нем число узлов четное.

В рамках одного кластера у вас может быть несколько raid волюмов